spark从1.6.0开始内存管理发生了变化,原来的内存管理由StaticMemoryManager实现,现在被称为Legacy,在1.5.x和1.6.0中运行相同代码的行为是不同的,为了兼容Legacy,可以通过spark.memory.useLegacyMode来设置,默认该参数是关闭的。

前面有一篇介绍spark内存管理的文章spark内存概述,现在介绍1.6.0的内存管理,由UnifiedMemoryManager实现。

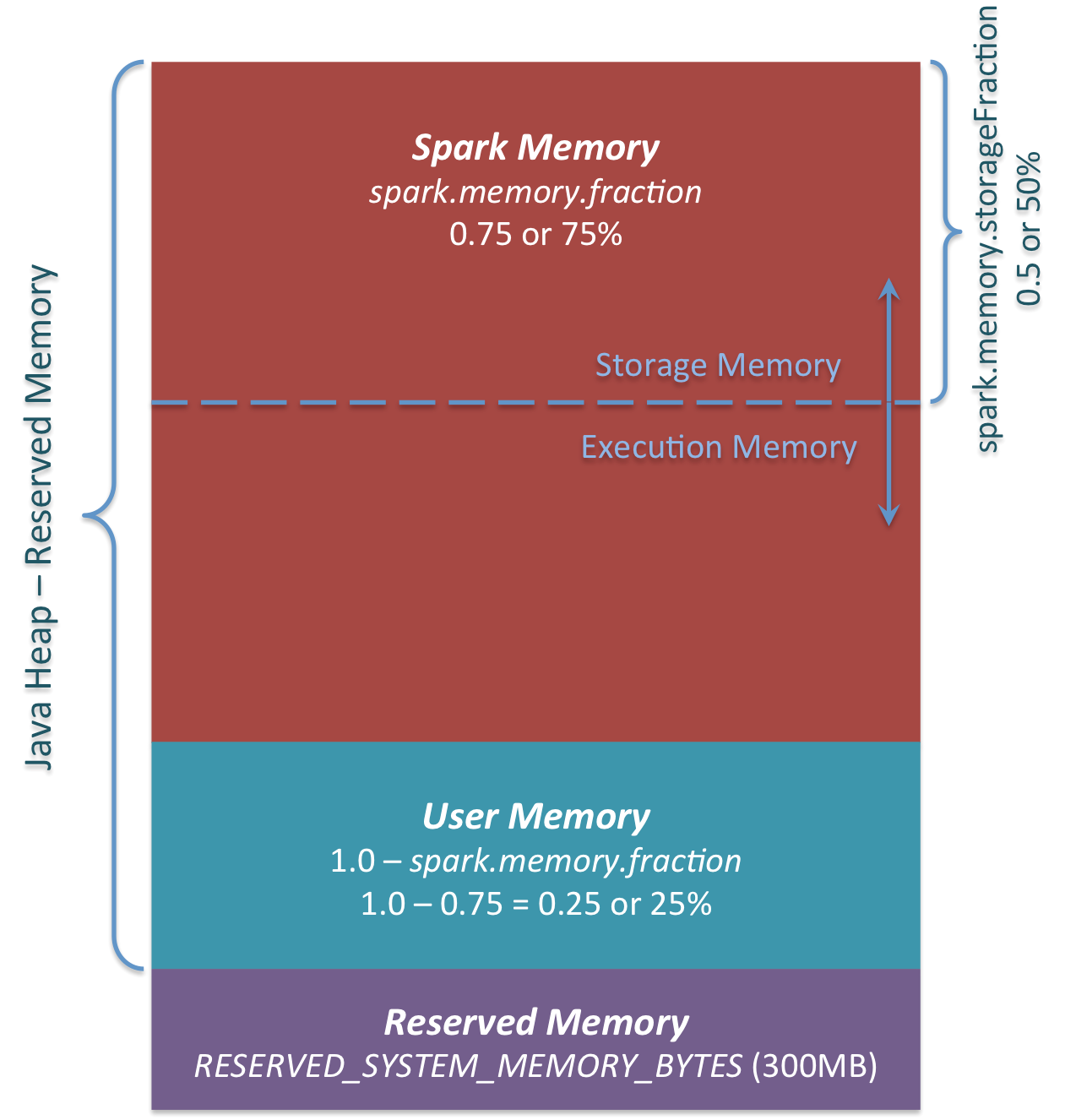

1.6.0的统一内存管理如下:

Spark-Memory-Management-1.6.0

Spark-Memory-Management-1.6.0

主要有三部分组成:

1 Reserved Memory

这部分内存是预留给系统使用,是固定不变的。在1.6.0默认为300MB(RESERVED_SYSTEM_MEMORY_BYTES = 300 * 1024 * 1024),这一部分内存不计算在spark execution和storage中,除了重新编译spark和spark.testing.reservedMemory,Reserved Memory是不可以改变的,spark.testing.reservedMemory不推荐使用在实际运行环境中。是用来存储Spark internal objects,并且限制JVM的大小,如果executor的大小小于1.5 * Reserved Memory = 450MB ,那么就会报 “please use larger heap size”的错误,源码如下。

val minSystemMemory = reservedMemory * 1.5

if (systemMemory < minSystemMemory) {

throw new IllegalArgumentException(s"System memory $systemMemory must " +

s"be at least $minSystemMemory. Please use a larger heap size.")

}

2 User Memory

分配Spark Memory剩余的内存,用户可以根据需要使用。可以存储RDD transformations需要的数据结构,例如, 重写spark aggregation,使用mapPartition transformation,通过hash table来实现aggregation,这样使用的就是User Memory。在1.6.0中,计算方法为(“Java Heap” – “Reserved Memory”) * (1.0 – spark.memory.fraction),默认为(“Java Heap” – 300MB) * 0.25,比如4GB的heap大小,那么User Memory的大小为949MB。由用户来决定存储的数据量,因此要遵守这个边界,不然会导致OOM。

3 Spark Memory

计算方式是(“Java Heap” – “Reserved Memory”) * spark.memory.fraction,在1.6.0中,默认为(“Java Heap” – 300MB) * 0.75。例如推的大小为4GB,那么Spark Memory为2847MB。Spark Memory又分为Storage Memory和Execution Memory两部分。两个边界由spark.memory.storageFraction设定,默认为0.5。但是两部分可以动态变化,相互之间可以借用,如果一方使用完,可以向另一方借用。先看看两部分是如何使用的。

-

Storage Memory 用来存储

spark cached data也可作为临时空间存储序列化unroll,broadcast variables作为cached block存储,但是需要注意,这是unroll源码,unrolled block如果内存不够,会存储在driver端。broadcast variables大部分存储级别为MEMORY_AND_DISK。 -

Execution Memory 存储Spark task执行过程中需要的对象,例如,Shuffle中map端中间数据的存储,以及hash aggregation中的hash table。如果内存不足,该空间也容许spill到磁盘。

Execution Memory不可以淘汰block,不然执行的时候就会fail,如果找不到block。Storage Memory中的内容可以淘汰。Execution Memory满足两种情况可以向Storage Memory借用空间:

-

Storage Memory还有free空间 -

Storage Memory大于初始化时的空间("Spark Memory" * spark.memory.storageFraction = (“Java Heap” – “Reserved Memory”) * spark.memory.fraction * spark.memory.storageFraction)

Storage Memory只有在Execution Memory有free空间时,才可以借用。

网友评论